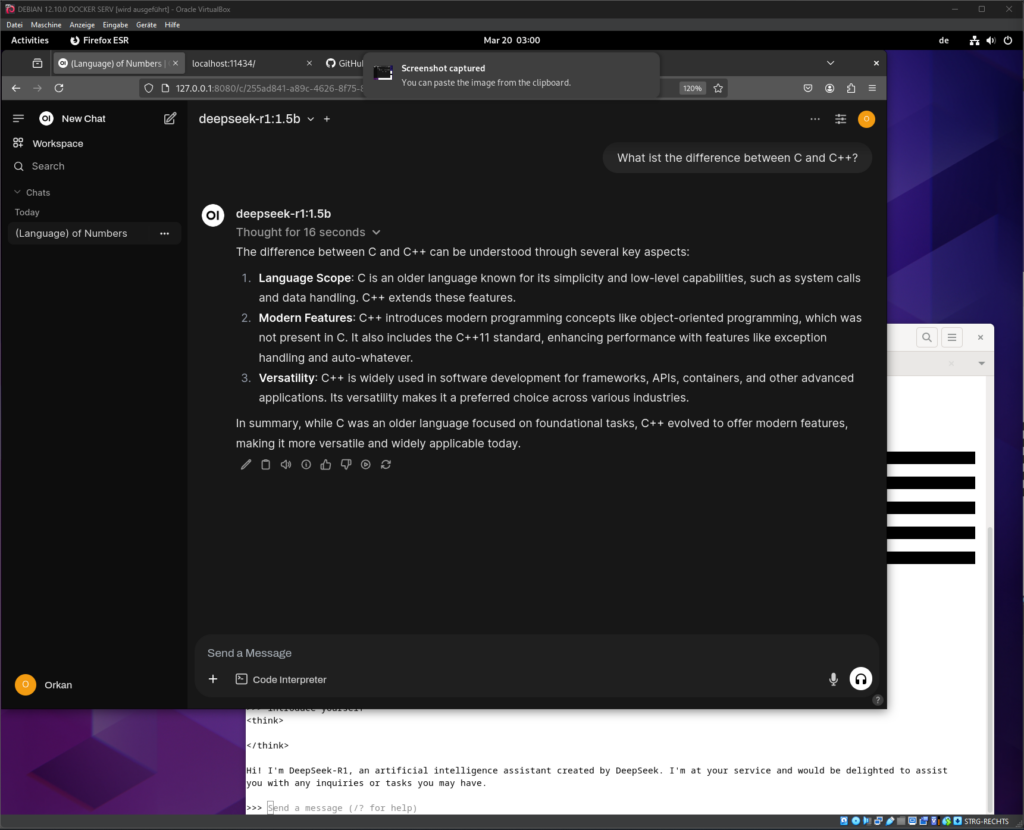

Heute habe ich – obwohl schon länger vorgenommen – eine lokale Installation von Large Language-Modellen auf Basis einer Debian 12.10 Vbox, Ollama (LLM Runtime) und OpenWebUI (Docker Image) sowie Deepseek-r1:1.5b (China-LLM mit Reasoning) getestet. Bisher basierte die Nutzung oder Tests solcher Lösungen auf deren Online-Plattformen oder durch Inanspruchnahme ihrer APIs). Ziel war es einerseits die Leistungsfähigkeit lokaler Installationen zu testen, andererseits die Performance auf handelsüblicher Hardware zu spüren.

Ich muss sagen, das ist wirklich beeindruckend und es läuft mit dem kleinsten Modell (1.5b) von Deepseek-r1 bei meinem Setup mit lediglich 4 virtuellen CPUs und 8 GB Ram, auch ohne GPU Unterstützung recht akzeptabel. Allerdings ist das 1.5 Milliarden Parameter Modell von Deepseek-r1 wirklich nicht für mehr als allgemeine Anfragen zu gebrauchen. Wer mehr will, muss einen leistungsfähigeren Server einsetzen und die umfangreicher trainierten Modelle für seine Ansprüche heranziehen. Dann wären 32b oder gar 70b möglich. Modelle, die darüber hinaus gehen, sind im eigenen Betrieb womöglich teurer, da sie wesentlich höhere Hardware- und Betriebsleistungen voraussetzen.

Unternehmen, die Bedenken bezüglich Datensicherheit sowie Datenschutz haben, dennoch nicht auf die täglich sinnvolle Unterstützung durch LLMs verzichten wollen, können mithilfe lokaler Installation von LLMs wie Llama, Deepseek, Grok, Mistral oder Gemma3, die Integrität genutzter Informationen wesentlich besser kontrollieren, Multiuser Unterstützung inklusive. Auch Installationen in einer Private Cloud sind natürlich gleichermassen möglich.

Das ganze Individual-Konstrukt ist ebenso mit vorhandenen Abos per API Anbindungen kombinierbar. Selbst die Integration von lokalen „Stable Diffusion“ Modellen für die Bildgenerierung ist möglich, ohne sich über das Urheberecht streiten zu müssen.

Probiert es aus. Unternehmen, die sich bei der Einführung lokaler KI-Systeme nicht sicher sind, ob diese den eigenen technischen, organisatorischen sowie ethischen Regelwerken, Datenschutzrichtlinien sowie den Gesetzen entsprechen, biete ich gerne Unterstützung bei der Analyse, Evaluierung und Konzeption sowie Prüfung an.

Denn bei möglichen Errungenschaften im Werdegang sind Risiken und Chancen abzuwägen.