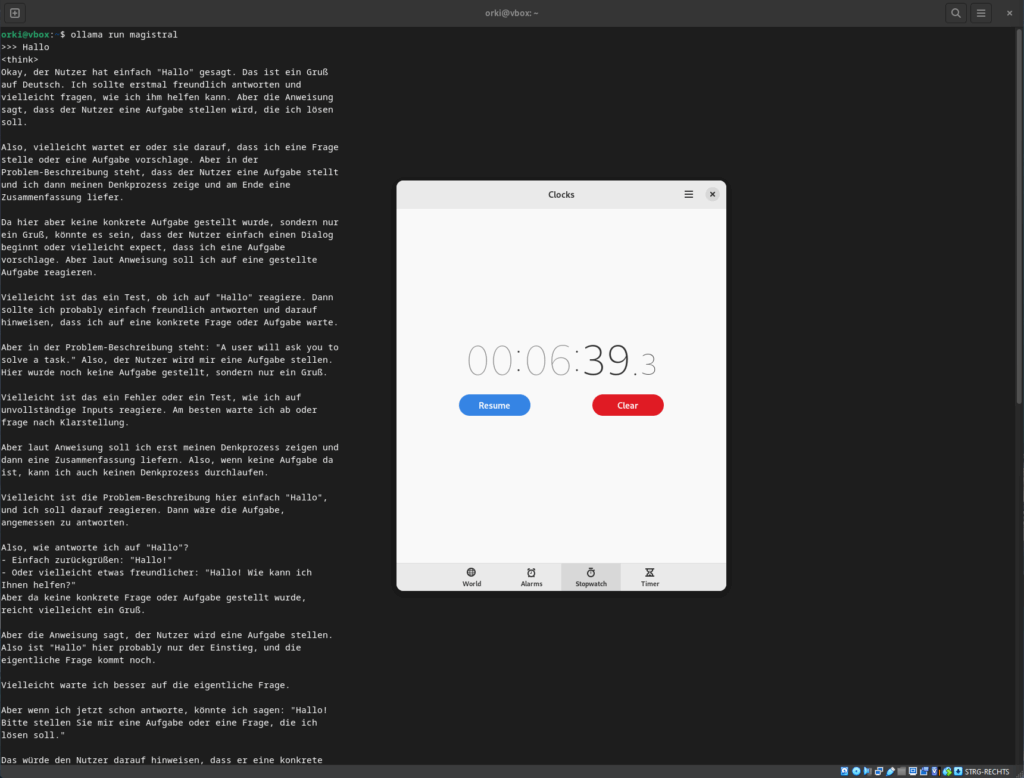

6 Minuten und 39 Sekunden!!!

Soviel Zeit hat es benötigt um mein Hallo, mit einem einfachen Hallo zu erwidern – mit zuvor ausgegebenem, 2-seitigen Reasoning-Text!

Warum der ganze AGI-Quatsch ein Hype ist, lässt sich an diesem Beispiel einfach erklären:

Ein zwei jähriges Kind winkt oft zurück, wenn man dem Kind mit Hallo zuruft. Ein 80 jähriger Mann, der das meiste Leben mit riesen Erfahrungen hinter sich gelassen hat, tut i.d.R. das gleiche.

Der Unterschied? Beide haben völlig unterschiedliche Voraussetzungen, doch beide haben die intuitive Gabe, etwas gelerntes im gleichen Muster zu speichern, wenn nötig jedoch blitzschnell zu überschreiben.

Ein LLM hingegen, lebt sein Wissen nur im Kontext und wiederholt das Muster für jede gleiche Situation auf das Neue.

Ich habe diesen Test auf einem virtuellen Linux durchgeführt, mit zugewiesenen 8 CPU Kernen und 48 GB Ram. Hätte ich ein ganzes Rechen-Cluster, hätte die Antwort gewiss nur Sekunden gedauert. Es geht bei der KI also nicht immer um die Kunst der Intelligenz, sondern um die Rechenleistung. Wenn Menschen in der Lage wären, ihre neuronalen Netze zusammen zu schliessen und sich nur auf eine Aufgabe konzentrieren könnten, wären sie womöglich im Berechnen genauso schnell wie die Supercomputer von heute, z.B. die hinter ChatGPT. Wenn man ChatGPT aber in mein heimisches virtuelles System übertragen würde, wäre jedes 2 jährige Kind schneller im „Hallo“ sagen als OpenAI’s Plapperbox.

Es geht also nicht um die Fähigkeit intelligenter zu sein, sondern aus dem vorhandenen Wissen schneller neue Muster und Erkenntnisse schlusszufolgern. Da ist die auf Halbleiter basierende KI, die letztlich nichts anderes macht als rechnen, in vielerlei Hinsicht schneller als das menschliche Gehirn. Dennoch wird es noch lange kein AGI erreichen. Denn dazu braucht es die Evolution, und sicher keine CPUs um LLM-Programme ablaufen zu lassen. LLMs basieren auf künstliche neuronale Netze, aber sie laufen auf CPUs, die nichts anderes können ausser zu addieren. Wenn man ihnen das Addieren weg nimmt, stürzen sie ab, ausnahmslos. Selbst eine Magistral LLM muss erst einmal aufgerufen werden, damit sie was tun kann. Das ist nicht das Gleiche wie wir funktionieren.

Ich bin kein AI Sientist, kein Physiker, kein Biologe und kein Neuro-Wissenschaftler. Ich bin nur ein Informatiker. Ich habe mir einige Learning Modelle und künstliche Neuro-Netze angeschaut und kann sagen, dass die generelle Intelligenz (AGI) mit heutigen Mitteln allenfalls eine extrem schlechte Kopie eines Menschen werden wird, denn unser menschliches Bewusstsein basiert nicht auf Additionen in Chips und Microcontrollern, neuronale Netze hin oder her.

Nehmen wir an, ich würde Schach gegen diese „Magistral LLM“ von Mistral auf dieser virtuellen Maschine spielen. Was meint ihr, wer in diesem Fall mehr Zeit hätte um seine Züge voraus zu kalkulieren? Intelligenz ist nicht nur Wissen oder Rechenleistung.

Wir brauchen keine 6 Minuten und 39 Sekunden für ein einfaches Hallo-Reply.