.

Der Markt der Suchmaschinen ist stark umkämpft und so versucht jeder Anbieter einer Suchmaschine dem Internet-User die Nutzung durch die individuellen Vorzüge, exklusiven Eigenschaften, Schnelligkeit bei der Suche durch immer ausgeklügeltere Suchalgorithmen aber auch durch Einsatz von Intelligenz und Semantik zum möglichst genauen und gezielten Suchergebnis dauerhaft schmackhaft zu machen.

Weitere Kriterien bilden Nutzbarkeit, analytische Suchen, Anonymität oder gezielte Werbeeinblendung. Andere wiederum bieten dem Kunden gleich alle angebotenen Dienste über die eine Plattform. Die Suchmaschine als Drehkreuz für Anwendungen wie Email, Videos, Social Network, Office etc.

Der Markt der Suchmaschinen ist ein hartes Geschäft und wer nicht gerade an Verschwörungstheorien glaubt oder aus Antipathie gezielt die Suchmaschine eines ganz bestimmten Anbieters meidet, der wird wahrscheinlich zu den 99% gehören, die selbst Internet URLs im Suchfeld von Google eingeben, um auf eine Webseite zu gelangen, dessen URL man ja bereits kennt. Ja das gibt es tatsächlich zu oft. Viele Anwender wissen nicht einmal, dass es eine URL Zeile im Browser gibt. Stattdessen nutzen sie das Suchfeld von Google, welches in Google’s Browser Chrome ohnehin standardmässig als Startseite eingestellt ist und bei Firefox mit einem Co-Branding ausgestattet auf Google’s Suchmaschine verlinkt. Wer noch den Internet Explorer im Einsatz haben sollte, landet demnach standardmässig auf Microsoft’s Suchmaschine Bing. Wer Firefox unter Linux benutzt, wird jedoch feststellen, dass manche Distributionen das Grund-Setup von Firefox aus ihren Distributions-Repositories verändert haben (z.B. Ubuntu und Derivate) und nun die Suchmaschine DuckDuckgo in der Basiseinstellung verwendet. Ich persönlich mag DuckDuckgo ebenfalls, da es mehr Anonymität verspricht und kein Nutzerverhalten wie Quellinformationen sowie Suchanfragen mitschneidet. Zudem ist DuckDuckgo im Gegensatz zu Google eine reine Suchmaschine. Es gibt jedoch noch Optimierungsbedarf in den Suchalgorithmen sowie im Umfang und Ranking der Ergebnisse von DuckDuckgo.

Es ist für die Konkurrenz von Google ziemlich schwer geworden, User abzuwerben oder viele neue Benutzer davon abzuhalten, ihre Suchmaschinen und damit auch andere Dienste in Anspruch zu nehmen, als die des Internet-Giganten. Google hat es bereits viel früher verstanden, dass das Abrufen von Wissen im Netz wesentlich wichtiger werden würde als die Inanspruchnahme von Standarddienstleistungen. Zudem war es einfacher darüber gezielt um weitere Dienstleistungen zu werben und sie auch gezielt mit weiteren Angeboten zu verknüpfen. Heute kommt kaum ein Android User mehr ohne die Dienste von Google aus, denn auch die SmartPhone OS aus dem gleichen Hause ist stark mit dem Mutterschiff vernetzt: Ob Suche, Emails, App-Store, Maps oder Youtube Videos…. Wer auf Android nicht verzichten will aber dennoch Google-frei durch das Leben gehen will, der wird ohne ein von Google befreites Custom-ROM und alternativen App-Stores nicht weiterkommen. Denn die Google- oder Co-Branded-Roms sind ebenfalls mit dem Google-Layer fest verdrahtet. Falls sie im Besitz eines handelsüblichen Android Gerätes sind, versuchen sich doch z.B. einmal die Youtube App über den App Manager zu deinstallieren. Über die normalen Wege ist dies leider nicht möglich. Sie müssen schon z.B. über die adb shell gehen oder das System über andere Wege “vergewaltigen”.

Bleiben wir jedoch bei dem Konkurrenzkampf der Internetgiganten Google, Microsoft, Yahoo & Co. welche sich wie gesagt nichts dabei schenken, wenn es um die Werbung ihrer Nutzer geht. Diesbezüglich beobachte ich jedoch eine interessante Anomalie, welches eindeutig den Search Bots von Microsoft zuzuordnen ist. Ein Webserverbetreiber ist in der Lage, umfangreiche Logs über verschiedene Aktivitäten seines Servers und seiner Webseiten, ggf. unter Differenzierung von virtuellen Host und Domains zu sammeln und auszuwerten. So können z.B. neben üblichen Informationen wie Client IP Adresse, besuchte Webseite und weitere Zugriffsinformationen auch Informationen des HTTP USER AGENTS (Der zum Einsatz gekommene Webbrowser und Betriebssystem, sofern nicht durch den Benutzer verändert) gesammelt und ausgewertet werden. Das hilft oftmals um statistisch zu ermitteln, welche Webbrowser und Betriebssysteme am meisten zum Einsatz kommen, um die Webseiten auf diese Werkzeuge und Systeme hin zu optimieren.

Intelligente Auswertungssoftware für Logdaten helfen dabei dem Web-Administrator, Spross von Weizen zu trennen. Haben sie sich schonmal gefragt, wie denn diese Suchmaschinen alles über ihre Webseite wissen, bzw. wie sie an soviele Informationen kommen, dass im Grunde erst dann eingesehen wird, wenn ein Besucher ihre Webseite betritt? Suchmaschinen machen im Grunde nichts anderes, als einen Besuch einer Webseite zu automatisieren und alles aufzusaugen, was sie so in die Hand bekommen können. Durch die heutige, sogenannte SEO (Search Engine Optimisation) kann der Webseitenbetreiber zusätzliche Indizes und Informationen bereitstellen, die es den Suchmaschinen helfen sollen, Informationen über eine Webseite optimierter und gezielter auszuwerten. Eine Optimierung seitens der Betreiber über Google Analytics beispielsweise, ist der umgekehrte weg dieser Abfragen seitens der Maschinen. Man kann es auch als eine Art Booster bezeichnen, welches das Erlangen und Bereitstellen gezielter Informationen beschleunigen soll. Somit gelangt man durch semantische Aufbereitung von Informationen und durch die Popularität einer Webseite weit nach Oben der Suchmaschinenergebnisse beim suchen. Das ist dann das sogenannte Ranking der Suchmaschinenbetreiber. Es ist wie Youtube: Je leichter auffindbar und populär, desto mehr klicks.

Suchmaschinen durchforsten das Internet nach Webseiten, machen sich DNS und IP Datenbanken zu Nutze um das gesamte Internet nach indexierbaren Informationen im WWW abzugrasen. Man könnte sie auch als Heuschrecken betrachten, die wirklich alles lesen und auswerten, worauf sie Zugriff haben. Ein anderes Beispiel könnte sein, dass man sie wie einen Staubsauger betrachten könnte, der zwar die Internetseiten nicht verschwinden lässt (zum Glück), aber eine Kopie dessen aufsaugt und verdaut. Dabei gehen Suchmaschinen viel weiter, als es ein normaler User manuell tun würde. Sie werden den Seitenquellcode aus, um ggf. Verzeichnissen und Verweisen zu folgen, um darin weitere nützliche Informationen über eine Webseite zu finden. Das nennt man dann auch “Crawling”.

Eine abgewandte Variante des Crawlings stellt das Web Reaping dar. Hier wird eine Web URL nicht nur gelesen sondern der Reaper versucht die Webseite samt allen zugänglichen Ressourcen zu kopieren. Einige Reaping Anwendungen werden gerne in der Tourismusbranche gestrickt, um zum Beispiel Flugpreise zu ermitteln oder automatisierte Flugbuchungen für Kunden auf der Seite einer Fluggesellschaft vorzunehmen, welche in der Regel keine Schnittstellen zu einem FLugticket Anbieter bereitstellt, oder die Online Flugticket Verkaufsagentur sich die teuren Lizenzkosten sparen möchte. Dann werden Flüge automatisiert auf den Webseiten der Fluggesellschaft im Namen des Gastes gebucht, während der Gast den Flug auf den Webseiten der Agentur bezahlt. In der Regel kommen dann kleine Agenturgebühren auf den Flugpreis drauf, welches der Käufer nicht merkt, da die Agentur die Bezahlung der Fluggesellschaft mit eigenen Zahlungsmitteln übernimmt. Das ganze sieht dann für die Fluggesellschaft so aus, als ob man den Flug manuell, also händisch gebucht hätte. Tatsächlich sind aber automatisierte Buchungsscripte dahinter, welche genau wissen, wie sie einer Webseite die Daten automatisiert übergeben müssen.

Was die intelligenten Logdaten Auswertungssoftware betrifft, kann der Web-Administrator bei der Auswertung bestimmen, ob der wiederum von der Software registrierte Suchmaschinen bei der Auswertung seiner Webserver-Logdaten auslassen möchte, oder diese selektiv mitauswerten will. Die meisten Web-Administratoren lassen jedoch die Auswertung von Zugriffen seitens der Suchmaschinen aus, da diese ggf. auch mehrmals am Tag eine Indizierung der Webseiten vornehmen können und dies entsprechend eine Menge Logdaten verursacht. Bedenken wir erneut, dass Suchmaschinenzugriffe sehr Verkehrslastig sein können und entsprechend viele Logdaten erzeugen.

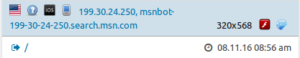

Seit einiger Zeit beobachte ich bei der Auswertung meiner Serverdaten jedoch, dass entgegen dem Wunsch an meine Logdaten-Analysesoftware, die Zugriffe seitens der Suchmaschinen auszublenden, ein ganz bestimmter Crawler immer wieder durch mein Filter durchschlüpft. Manche Webseitenbetreiber verhindern sogar die Indexierung ihrer Webseiten durch den Einsatz der “Robots” Steuerungsdatei. Die Datei selbst heisst ganz einfach “robots.txt” und ist eine Textdatei mit entsprechenden Anweisungen für Suchmaschinen. Man muss jedoch wissen, dass es im Ermessen der Suchmaschine liegt, ob sie die Ablehnung der Indexierung einer Webseite respektiert, oder diese ignoriert. Die robots.txt kann es nur maximal einmal pro (Sub-)Domain geben und muss unter diesem Namen (alle Buchstaben klein geschrieben) im Wurzelverzeichnis des Webserver-Verzeichnisse der jeweiligen Domain abgelegt werden.

Es ist mit dieser Technik also nicht möglich, Webseiten vor dem Zugriff durch Suchmaschinen oder manuellen Zugriffen zu schützen. Es ist lediglich möglich, das Erscheinen einer Webseite und dessen Inhalt in den Suchergebnissen einer Suchmaschine zu steuern. Es besteht zudem wie bereits erwähnt keinerlei Garantie, dass sich Suchmaschinen an die Verbots-Anweisungen in der robots.txt halten. Die überwiegende Mehrheit der Robots/Crawler moderner Suchmaschinen berücksichtigen bzw. respektieren das Vorhandensein einer robots.txt. Suchmaschinen, die mit fragwürdigen Absichten das Web durchsuchen, halten sich vermutlich nicht daran. Denkbar wäre es beispielsweise, dass die NSA ihre eigene Suchmaschine aufgebaut hat und das Internet unter Ignorierung dieser Datei versucht vollständig zu indexieren.

Ich komme jedoch zurück zu der besagten Anomalie, die ich nun an meinem Webserver bzw. auf meinen Webseiten seit einiger Zeit beobachte. Abgesehen davon, dass ich zwecks regulärer Indexierung meiner Webseiten durch die Suchmaschinen keine robots.txt Datei einsätze und somit es den seriösen Suchmaschinen erlaube meine Seiten zu indexieren, werte ich aus Sicherheitsgründen bestimmte Logdaten meines Webservers aus. Auch meine Seiten werden oftmals von Spamern oder von Einbruchversuchen heimgesucht. Oftmals sind es Zugriffe aus Ländern, die man im Normalfall nicht auf seinen Webseiten als Besucher vermuten würde. Daher fällt es einem Web-Administrator umso leichter, suspekte oder potenziell bösartige Zugriffe zu identifizieren und die Fälle zu analysieren. Meine Log-Auswertungen erfolgen dabei dahingehend, dass ich die Zugriffe seitens der Suchmaschinen, also die Logs, welche durch diese Zugriffe erzeugt wurden, ausblende bzw. filtere. Seit einiger Zeit ist es jedoch der Fall, dass ich trotz meiner Standardfilterregeln, welche bislang immer gegriffen hatten, eine Suchmaschine immer wieder den Weg in meine Auswertung findet.

Es handelt sich hierbei um einen ganz bestimmten Robot/Crawler von Microsoft, dem MSN Search bzw. BING. Zuerst dachte ich, es sei ein “Referrer”, also eine Weiterleitung bzw. Verlinkung durch die Suchmaschine, worüber ein Benutzer den Weg zu meinen Webseiten finden würde. Aber nach genauer Beobachtung stellte ich fest, dass es sich bei den Logdaten nicht um eine Referring Domain (MSN Search) handelt, sondern um einen direkten Zugriff seitens dieser. Das interessante dabei ist es, dass Microsoft anscheinend die Art seiner Zugriffe auf Webseiten, durch seine Suchmaschine vortäuschend realisiert. Da Suchmaschinen in der Regel keinen Webbrowser für die Indexierung des WWWs zum Einsatz bringen (das ist soweit logisch denke ich), setzen sie für die Zugriffe automatisierte Scripte mit entsprechend eigenen HTTP USER AGENT Angaben ein. Google z.B. gibt bei seinen Crawlern zwecks Indexierung von Webseiten folgende Angaben als User Agent mit:

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

(Alle User Agent Angaben von Google’s Crawlern gibt es hier: Google Crawler

Nun ist es anscheinend der Fall, der Microsoft tatsächlich an seinen MSNBOT HTTP USER AGENT Angaben rumgefeilt oder umgestellt hat, so dass neuerdings die MSNbots bzw. BINGBots nurnoch mit dem folgenden User-Agent Angaben das Web auf eine ganz spezielle Art indexieren (Auszug aus meinen Logdaten):

Mozilla/5.0 (iPhone; CPU iPhone OS 7_0 like Mac OS X) AppleWebKit/537.51.1 (KHTML, like Gecko) Version/7.0 Mobile/11A465 Safari/9537.53 BingPreview/1.0b

Microsoft bzw. Bing gibt unter seiner Webseite bezüglich seiner Crawler jedoch unter dem Botnamen “BingPreview” was völlig anderes vor. Hier stimmt also das, was Microsoft tut und angibt nicht überein. Denn wenn man den Webseiten von BING Vertrauen schenken darf, dann müsste der USER-AGENT, den BING bei seinen Crawling Aktivitäten für das angebliche “Page Snapshot” folgenden USER-AGENT nutzen:

Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/534+ (KHTML, like Gecko) BingPreview/1.0b

oder

Mozilla/5.0 (Windows Phone 8.1; ARM; Trident/7.0; Touch; rv:11.0; IEMobile/11.0; NOKIA; Lumia 530) like Gecko BingPreview/1.0b

BING Selbst gibt, was den BingPreview Crawler betrifft, folgende Hinweise zu diesem Crawler:

BingPreview is used to generate page snapshots. You can find more details about Bing Preview here. Note that BingPreview also has “desktop” and “mobile” variants.

Es ist also deutlich zu beobachten, dass BING neuerdings einen Crawler einsetzt, der als HTTP USER AGENT weder die von BING angegebenen Werte nutzt, noch sich an die Angaben von BING hält, angeblich für “Page Snapshotting” zuständig zu sein. Denn diesem neuartigen Crawler am ähnlichsten scheint BING’s normaler Web-Crawler mit seinen USER AGENT Angaben zu kommen:

Mozilla/5.0 (iPhone; CPU iPhone OS 7_0 like Mac OS X) AppleWebKit/537.51.1 (KHTML, like Gecko) Version/7.0 Mobile/11A465 Safari/9537.53 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)

Die Fragen, die man sich hierbei stellen sollte sind zumindest aus meiner Beobachtung und Sicht:

-

Warum setzt Microsoft einen Crawler ein, dessen HTTP USER AGENT seitens Microsoft nicht dokumentiert bzw. veröffentlicht wurde?

-

Warum setzt Microsoft für das normale Web Crawling, also die Indexierung der normalen Webseiten einen Crawler ein, der sich als Mobiles Gerät ausgibt, die Anfragen angeblich von einem Apple Safari Webbrowser stellt?

-

Warum gaukelt Microsoft den besuchten Webseiten somit vor, ein Endbenutzer mit einem mobilen Gerät und einem manuellen Zugriff zu sein (immerhin mit “BingPreview”)?

-

Hat Microsoft jetzt vor, durch Anpassungen seiner Crawler-Identifikatoren eine Grauzone zu nutzen und somit womöglich das Umgehen von robots.txt diverser Webseiten zu legitimieren?

-

Will Microsoft somit womöglich mehr Daten und Informationen sammeln als seine Konkurrenten, die sich evtl. an die Regeln halten? Das würde zumindest einen Vorteil an BING verschaffen, mehr zu indexieren als alle anderen.

-

Oder Ist Microsoft einfach nur dabei seine Systeme und Prozesse umzustellen oder an neuen mobilen Crawling/ Search Engine Techniken zu feilen so dass sich nur ein Fehler eingeschlichen hat?

Ich habe zumindest nichts dagegen, dass Microsoft bzw. BING seine Crawler auf meine Webseiten loslässt. Es nervt mich jedoch, dass ich meine Filter anpassen muss und vorgegaukelt bekomme, es würde sich dabei um Zugriffe von einem mobilen Gerät handeln, was ja sowas von utopisch wäre. Zumindest ist es auch eindeutig zu erkennen, dass dieser Crawler von Microsoft lediglich an der Landing Page meiner Webseite interessiert ist, also an der Startseite. Das würde zumindest die Erklärung von Microsoft belegen, dass sie mit dem BingPreview Crawler lediglich ein “Page Snapshot” machen und somit die erste Seite einer WWW Domain als Bilddaten abspeichern bzw. indexieren. Das beruhigt ein wenig, ist jedoch wiederum bedenklich, wenn z.B. ein Webseitenbetreiber gleich auf der ersten Seite sein Bild veröffentlicht hat. Dann landen auch gleich persönliche Bilder bei Microsoft, welche im Nachgang schwer zu entfernen sein dürften. Aber wer schon sein Bild im Internet veröffentlicht, der muss nun damit rechnen, dass es vor Microsoft noch viele andere bösartige Quellen existieren, bei denen man kopierte Bilder nicht ohne weiteres wieder entfernen lassen kann 🙂

Natürlich habe ich genau diesen einen Crawler versucht hinsichtlich seines OS zu identifizieren. Aber da die eigentlichen Systeme hinter den Firewalls von Microsoft hängen und es sich bei der protokollierten IP vermutlich um eine NAT Adresse handelt, ist es schwierig zu identifizieren, welches Betriebssystem Microsoft tatsächlich für das Crawlen des Internets einsetzt. Ich gehe aber stark davon aus, dass es sich hierbei um die eigenen Betriebssysteme handelt haha 😀 (Oder stellt Microsoft nun auf Mac/OSx um? 😀 )

Haben sie schonmal versucht mit einem IPhone das gesamte Internet zu crawlen und dann für ihre Suchmaschine zu indexieren?? Na dann viel spass 🙂 Vielleicht in 10 Jahren. Aber dann können wir auch mit einem Auto ins Weltall fliegen, mit dem Hauptcomputer im Zigaretttenanzünder.

(red)

Update 16.11.16: Inzwischen scheint Microsoft die Angabe des User Agents erneut angepasst zu haben. Die Anomalie ist seit gestern verschwunden.