Einleitung

Haben sie sich in den letzten Wochen, Monaten oder am besten Jahren über die Sicherheitsmeldungen der Medien einmal informiert? Haben sie auch das Gefühl, dass die Anzahl der Bedrohungen, der Einbrüche, des Datenklau, der Kompromittierungen exorbitant gestiegen sind? Haben Sie sich einmal gefragt, woran das liegen könnte?

Sicher hat es etwas damit zu tun, dass wir weg vom Industriezeithalter, hinein in das Technologiezeitalter unsere Welt mit diesem Über-hype belegt, ausgebaut und es damit, zumindest technisch vorangetrieben haben, rein quantitativ. Die bekannten und unbekannten Bedrohungen und Risiken steigen proportional zu der Menge der bedrohten Technologie, die wir tag täglich zum Einsatz bringen, um nicht zu sagen, rund um die Uhr in Betrieb haben. Das ist Mathematik aus der Grundschule.

Wenn wir über Bedrohungen reden, denken wir dabei zwangsläufig an Bedroher. Wenn wir die Bedroher klassifizieren wollten, würden wir wohl aktuell vier Hauptgruppen definieren.

– Die (leider) staatlich legitimierte Bedrohung (Überwachung, Ausspähung, Spionage),

– die privat gruppierte Bedrohung (Hackergruppierungen, Untergrundorganisationen etc.),

– die Einzel- oder Wiederholungstäter und

– wir selbst!

Habe ich was vergessen? Aliens vielleicht. Aber die haben sich noch nicht bekannt zu irgendwelchen Hacks.

In diesem Thema geht es jedoch nicht darum die Wahrheitsfindung zu unterstützen. Auch geht es nicht darum ein auf analytischen Fakten basierendes „Security Survey“ aufzustellen. Diese Surveys gibt es im Internet zu genüge. Die Big 4 machen es, Verizon macht es, Checkpoint macht es, etc. Es gibt unzählige, jährliche Berichte im Netz die uns u.a. aufzeigen, wo die Gefahren lauern, welche Bedrohungen am stärksten sind und wieviele befragte Firmen statistisch welchen Angriffen zum Opfer gefallen sind. Eine solche Summary zu bekommen ist für das Risiko Management zweifelsohne eine sehr wichtige Lektüre, um die stetige Verbesserung aufrechtzuerhalten. Es ist ein Kreislauf, wenn man es so will.

Was für viele selbstverständlich erscheint im Kreise des „Plan – Do – Check – Act“ Zyklus zu rotieren, ist für mich eine einzige Achterbahnfahrt. Haben sie sich die Darstellung zu solch einer Methodik einmal angeschaut? Es ist immer kreisförmig und sehr symmetrisch sowie absolut regelmässig. Also alles andere als unsere reale Welt, die mit Verzögerungen und Beschleunigungen, mit Tal- und Hochfahrten, einem Ungleichgewicht an Prioritäten und Tagesgeschehen behaftet ist. Ziel soll es sein, dieses Chaos methodisch zu harmonisieren. Ist ihr Unternehmen harmonisch? 🙂

Die gesamte Sicherheitsapparatur hat sich heute selbst zu einer Wirtschaftsapparatur entwickelt, in dem das vorgeworfene Unwissen welches in Risiken mündet, das Chaos, durch Methodik und Zwangsmassnahmen, vorgegeben durch Institutionen und vorgeschrieben durch Akkreditoren durchgesetzt werden soll. Das ist im Grunde auch nicht schlimm, wenn Kerndisziplinen wie Sicherheitsmanagement und Risikoreduktion systematisch und nach einem Plan erfolgt. Immerhin darf man von einem Service Provider nicht immer verlangen zu wissen, was ein zu implementierendes ISMS im Sinne eines ISO/IEC 27001 Standards ist und was es bezwecken soll. Auch kann man von einem Autovermieter am Flughafen nicht auf Anhieb erwarten, warum er die PAN und den Sicherheitscode (CVC2/CVV2) einer Kreditkarte nicht niederschreiben sollte.

Es ist also der Fall, dass Unternehmen sich heute nicht mehr allein auf ihr Kern-Business konzentrieren können, sondern Ihre Agilität und Ihre Handlungsfreiheiten durch viele äussere Faktoren beeinflusst werden. Man kann sich das auch so vorstellen, dass ein Programmierer auch etwas von Buchhaltung verstehen muss, wenn er im Auftrag seines Kunden eine Finanzbuchhaltungssoftware implementieren will, um den Auftrag zu bekommen.

Das Thema in diesem Beitrag ist jedoch nicht die Sinnhaftigkeit unserer heutigen Apparatur welches aus einer Notwendigkeit, einem Risikoverständnis heraus entstanden und heute durch das Security-Mainstream gelenkt wird, sondern warum die Zeit für ein Mind-Change ansteht.

Naivität durch Unwissen und Gewohnheiten

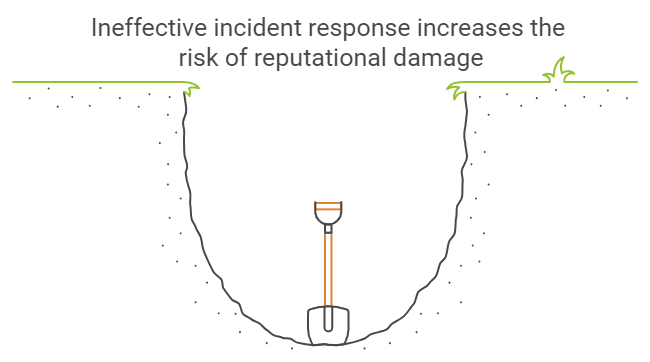

Bleiben wir bei Unternehmen, die ein gewisses Mass an Sicherheit, an nachweislicher Sicherheit benötigen um Bedrohungen entgegenzuwirken, Risiken zu minimieren und das Gesicht zu bewahren, sprich, Reputationsschäden zu vermeiden. Absolute Sicherheit ist nur eine Illusion wie sie alle wissen. In diesem Kontext bezeichne ich die Firmen als Dumm. Ja, die meisten Firmen sind dumm, wenn es um ihre Sicherheit geht. Das hört sich sehr gemein und arrogant an, in der Tat. Aber ich versuche diese pauschale Unterstellung aus einer gewissen Betrachtung heraus näher zu bringen. Die Naivität vieler Firmen hinsichtlich Sicherheitsbewusstsein kommt schlichtweg aus ihrem Unwissen, aus den fehlenden Erfahrungen und gewissermassen auch aus ihrer Lernresistenz, weil ihre Sicherheit eben für sie eine Notwendigkeit ist, viel mehr als das es ihr Kerngeschäft wäre. Also ist die Dummheit und Naivität vieler Unternehmen durch das natürliche Unwissen legitimiert. Natürlich haben viele von Ihnen auch Sicherheitsexperten und Systeme eingekauft. Doch wie sieht es mit deren Effektivität aus, wie die Motivation die Empfehlungen ihrer Experten auch tatsächlich umzusetzen? Haben sie es getestet? Ich meine, keine Pen-Tests, sondern ordentlich rangenommen?

Der diesjährige „Data Breach Investigations Report“ von Verizon belegt, dass z.B. die grössten kommerziellen Ransomware Attacken auf Banken und Versicherungen verübt wurden. Verständlich! Nun, die meisten Bankangestellten sind schlichtweg auf ihr Business konzentriert und haben keine Ahnung davon sich gegen Social Engineering- Phishing- oder Spam Angriffen zu wehren, worüber die Malware am meisten verbreitet wird. Ebenso haben sie natürlich sehr brisante und wichtige Daten und vor allem Das Geld, um Lösegeld zu zahlen. Welche Bank würde ihren Aktionären offen zugeben, im breiten Stil einer Ransomware Attacke zum Opfer gefallen zu sein? Solche Fälle tauchen in den Medien dann höchstens als „Betriebsstörungen“ oder „Stromausfall“ auf. Aber wie kann das passieren, und das bei Banken, die sich doch so stark schützen wollen und müssen?

Die stupiden Security Awareness Trainings, die man der gesamten Belegschaft aufgrund der Vorschriften alle Jahre wieder Eintrichtern muss, versagen genau in solchen Momenten der „Vergiftung“. Denn diese Trainings haben nicht die Effektivität die gewünschte Sensibilität allen Mitarbeitenden auf dem gewünschten Niveau einzutrichtern. Viele Firmen machen zudem in ihren jährlichen Revisionsprüfungen erfahrungsgemäss ihren Auditoren was vor, was die Nachweise dieser Erziehungsmassnahmen betrifft. Oftmals lässt sich dann auch noch das Management garnicht schulen, weil sie wichtigere Dinge über das ganze Jahr zu tun haben. Dabei sollten gerade die Führungskräfte ein absolutes Vorbild sein, was sie aber in keinster Weise sind. Eine weitere Meldung zu einem Betrugsfall in Millionenhöhe (Allein 3 mir bekannte in 2016) zeigt wieder einmal, dass mit der steigenden Hierarchiestufe die Awareness umso tiefer fällt. Fragen sie ihren Sicherheitsverantwortlichen, ob das Management geschult wird und ob sie sich an die Regeln halten. Nein, Geschäftsleitungsmitglieder sind wirklich überwiegend der Meinung, dass die Regeln für die Firma gemacht wurden, nicht für sie.

Die Methode des oder der Angreifer im obigen Link ist dabei gar nicht mal so raffiniert. Für einen unvorsichtigen Manager aber ggf. fatal und für den Angreifer effektiv. Ähnliche Angriffe habe ich einmal hautnah erlebt. In diesem Fall kam der Angreifer aus Israel, zumindest konnte ich Ihn bis dahin zurück verfolgen.

Für diesen Angriff nutzt der Angreifer die Ahnungslosigkeit des Opfers aus. Dieser ist meist ein ganz frischer aber ranghoher Mitarbeiter mit Finanzkompetenzen.

An den Mitarbeiter gelangt der Angreifer über die Veröffentlichungen in den Medien, z.B. die Bekanntgabe des neuen Managers (CEO oder CFO, etc.) im Unternehmen. Auch solche Manager von Firmen, die gerade frisch von einer anderen Firma übernommen wurden, sind mögliche potenzielle Opfer.

Der Trick ist banal, jedoch anscheinend effektiv zugleich:

1. Zuerst identifiziert der Angreifer eine ranghöhere Person im Unternehmen oder falls vorhanden, in der Muttergesellschaft, am besten den Global CEO o.ä.

2. Der Angreifer schreibt das Opfer mit einer gefakten Email-Adresse an, welche der originalen Firmen-Email-Adresse sehr ähnlich ist. Den Namen des Absenders kann man dabei ohnehin wählen wie man will und die meisten Empfänger achten auf die Namen, die wenigsten jedoch auf die Email-Adresse, geschweige denn die Herkunft.

3. In der ersten Email informiert der Angreifer (Der angebliche SuperBoss) das Opfer, dass er ihn wegen eines vertraulichen Deals oder „Due Dilligence“ informiert, welches der absoluten Geheimhaltung unterliegt und er sehr bald von einem Anwalt namens YX von der Kanzlei ABC kontaktiert werden würde.

4. Kurze Zeit später wird das Opfer tatsächlich von diesem angeblichen Anwalt XY von der Firma ABC kontaktiert (Telefonisch) und bezieht sich auf das vertrauliche Vorhaben der Gesellschaft und referenziert den vorgetäuschten „SuperBoss“. Das Opfer wurde ja bereits von diesem „vorinvormiert“. Die Anwaltskanzlei gibt es dabei tatsächlich, auch den Anwalt! Nur das hierbei eine Identitätstäuschung stattfindet 😉

5. Von diesem Zeitpunkt an läuft alles nur noch über den Anwalt oder halt einer berechtigten Person. Damit aber das Opfer nicht auf die Idee kommt, den SuperBoss proaktiv zu informieren, schreibt der Angreifer mit der ersten Adresse regelmässige Emails an das Opfer, z.B. wegen Statusreports, damit das Opfer lediglich auf die falsche Email-Adresse antworten muss und nicht proaktiv auf die Idee kommt den richtigen SuperBoss mit der richtigen Email anzuschreiben, wo in solch einem Fall alles auffliegen würde.

Die Masche ist denkbar einfach, aber genau bei diesen ranghohen Leuten u.U. auch super effektiv, vor allem lukrativ, sofern jemand wirklich neu im Unternehmen ist, oder das Unternehmen selbst erst kürzlich übernommen wurde und das ganze über die Medien inkl. aller wichtiger Namen bekannt gegeben wurde. An die Email-Adressen zu kommen, ist dann nurnoch ein Kinderspiel. Man erkennt in solchen Fällen, dass ein Unternehmen entweder keine internen Kontrollsysteme besitzen, oder in der Lage sind diese bei Bedarf auszuhebeln.

Mal abgesehen davon sind Manager das typische Bild dessen, was man in den unteren Schichten definitiv nicht sein möchte, es aber wird, je höher man steigt. Ich habe auch schon erlebt, dass alt eingesessene Mitarbeiter, die sich widerwillig neuen Regeln fügen mussten, ihre alten Gewohnheiten sofort wieder aufnahmen, sobald sie die Möglichkeit witterten, z.B. aufgrund eines Personalwechsels. Der Mensch ist ein Gewohnheitstier und wenn keine Konsequenzen befürchtet werden müssen, dann bricht er auch mal Regeln und Gesetze um seine eigenen Ziele zu erreichen, und wenn es das Bedeutet, andere Mitarbeiter auszuspähen und zu monitoren.

Auditoren hingegen legen den Schwerpunkt in solchen Prüfungen meist auf Vollständigkeit statt Effektivität. Es werden zwar Programmunterlagen gesichtet, aber niemand weiss, ob diese Programme auch tatsächlich so durchgezogen wurden, wie sie vorgetragen wurden oder ob alle Mitarbeitenden sich denn noch an den Inhalt erinnern, geschweige denn alles verstanden haben. Wer nicht unterschreibt, auch wenn er die Schulung nicht verstanden hat, macht sich keine Freunde und die interne Revision prüft auch nicht, ob es alle verstanden haben. Es ist zudem menschlich, dass vieles auch wieder nach kurzer Zeit vergessen wird. Der Mensch verdrängt themen, die er entweder nicht völlig nachvollziehen kann, oder die für ihn eine Sache der Notwendigkeit ist, daher weniger relevant erscheint. Oder denken sie etwa, dass sie ihren Mitarbeitenden durchweg auf einer PowerPoint Folie erklären können, warum die schützenswerten Assets denn so schützenswert sind? Ich habe unzählige Awareness Trainings gehalten und meine Anfangsfrage war in diesen Veranstaltungen an das Publikum immer die gleiche: „Was ist für sie in ihrem Unternehmen schützenswert?“. Sie wollen nicht wissen, wieviel Prozent der Antworten wirklich verwertbar waren, und das immer und immer wieder. Doch dies ist ein völlig anderes Thema und das Thema „Security Awareness“ würde mit „Sicherheit“ den Rahmen des Beitrags sprengen.

Der Mensch ist und bleibt das schwächste Glied

Sie haben sicherlich schon gehört, dass auf der diesjährigen DEFCON CTF Challenge eine neuartige „Machine Learning“ Technologie die technische Sicherheit unserer Systeme revolutionieren soll, in dem Maschinen beigebracht wird, Angriffe, Schwachstellen und Bedrohungen künstlich intelligent zu identifizieren und sein Selbstheilungsprozess anzustossen, welches z.B. das semi-manuelle Patching unserer Systeme, wie es z.B. ein ISO oder PCI DSS fordern, teilweise überflüssig machen könnte. Noch ist die Technik nicht genug fortgeschritten, da sie mit der aktuellen Maturität gegen den unberechenbaren Mensch nur durch dessen Zuhilfe effektiv genug ist, um sich vollständig (im Sinne der Möglichkeiten) zu wehren. Ein vielversprechender Ansatz und sicher auch sinnvoll die künstliche Intelligenz nicht nur in unsere Kühlschränke im Rahmen des IoT hypes einzubauen, sondern auch in unsere Serverlandschaften und in unsere Sicherheitssysteme.

Doch stellen sie sich jetzt einmal vor, wie der überwiegende Teil der Unternehmen davon überzeugt werden könnte, Produktions- und Betriebsverwaltungssysteme einer Abwehr- und Heilungsintelligenz anzuvertrauen, welches über die statische Funktion einer Firewall, einer WAF, eines Content Security Gateways oder einem IDS hinaus geht, den statischen Administrationsprozessen eines WSUS Servers entgegen, dann den Abwehr-Einsatz einleitet, wenn es dies für richtig hält. Sind Unternehmen denn bereit ihre instabilen Systemlandschaften einer solchen Intelligenz, hoffentlich unter der Überwachung und dem Notausknopf von Sicherheitsadministratoren zu überlassen? Ein CIO eines produzierendes Unternehmens hält doch jedes Mal die Luft an und wird dabei grün und blau, wenn seine Admins im Rahmen der vereinbarten Wartungsfenster alle 30 Tage die Systeme beginnen zu patchen. Seien wir mal ehrlich: quantitativ gesehen, haben viele dieser Firmen keinen Plan davon, ob ihr IT gestützter Betrieb nach einem monatlichen Patch-Marathon noch genau so laufen wird wie zuvor, einigermassen stabil, ohne grosse Fehler und vor allem ohne Ausfall ausserhalb dieser Wartungsfenster. Denken sie etwa, Unternehmen testen jeden anstehenden Patch und haben für alle kritischen Anwendungen und Systeme eine Testumgebung? Denken sie, die Ressourcen bzw. Mitarbeiter werden für solche sinnvollen Tests freigeschaufelt und können ein „GO“ zum produktiven Rollout mit reinem Gewissen geben? Glauben Sie, dass die meisten IT Abteilungen ein Change Management Prozess besitzen, und wenn, diesen auch einhalten? Wenn sie all das denken, möchte ich gerne in ihrer Traumwelt leben 🙂

Es wird also noch eine Weile dauern, bis Unternehmen diese Next-Generation Abwehr mit der automatisierten Selbstheilungsfähigkeit über sich ergehen lassen werden. Auf der einen Seite ist die Maturität dieser Möglichkeit als technische Lösung noch nicht so weit, auf der anderen Seite sind die Unternehmen selbst nicht soweit. Ich kann mir vorstellen, dass solche Lösungen erst einmal bei so genannten Security Operation Center (SOC) bei diversen Dienstleistern zum einsatz kommen wird, welche „Security Outsourcing“ und „Managed Services“ Dienstleistungen anbieten.

Die technische Hauptgefahr liegt in der Mainstream-Denke

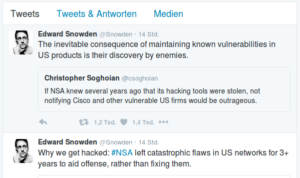

Es ist schwieriger Menschen zu verändern, als die vorhandene Technik. Das sollte uns allen soweit einleuchtend sein. Haben sie aber mal ihren Auditor oder Sicherheitsberater gefragt, was er denn ihnen empfehlen würde, weil sie gerade dabei sind eine neue Firewall-Infrastruktur zu konzipieren und dieses Konzept implementieren wollen, jedoch noch keine Herstellerauswahl getroffen haben? Ich kann ihnen versichern, dass die meisten Experten in diesem Bereich kaum über die Mainstream Anbieter hinaus eine alternative Lösung unterbreiten können, die sie besser schützen würde, als es diese Anbieter ihnen in ihren PR Kampagnen versprechen. Insteressant z.B. das solche Anbieter wie der Gigant CISCO sich damit rühmen, den besten Schutz für seine Kunden liefern zu können, jedoch seine Lücken erst durch die Bekanntgabe von ge-leak-ten NSA Tools per Zero-Day Lücken stopfen muss. Haben sich unsere Sicherheitsexperten mal abgesehen davon die Bug- und Vulnerability Liste von solchen Produkten einmal angeschaut? In deren Vulnerability Datenbank werden stand 18.08.2016 ganze 1962 Lücken gelistet, davon 148 als kritisch eingestuft. Unter Umständen ein Indiz dafür, dass Produkte ohne Marktreife auf den Markt geschleudert werden. Entwerfe –> bring es schnell zum laufen –> verkaufe –> warte ab was passiert.

—–

(Auszug aus: https://theintercept.com/2016/08/19/the-nsa-was-hacked-snowden-documents-confirm/)

Auch FortiGate ist von der Bekanntgabe betroffen und man fragt sich spätestens jetzt, ob man diesen namhaften Firmen bzw. ihren Produkten noch vertrauen kann. Es macht sich in meinem Kopf zumindest der Gedanke breit, ob die Hersteller ihre Produkte selbst vollständig auf Herz und Nieren prüfen oder geprüft haben. Immerhin reden wir hierbei um Produkte, die mich, mein Unternehmen schützen sollen.

Viele mittelständische und grosse Unternehmen greifen dennoch nach der Palette von CISO, Checkpoint, FortiGate oder Juniper. Diese nahmhaften Unternehmen sind deswegen namhaft, weil sie sich eben einen Namen gemacht haben. Nach meiner Erfahrung jedoch sicher nicht deswegen, weil sie vertrauenswürdiger sind, sondern weil sich sich über andere Wege und Massnahmen einen Namen geschaffen haben. Sicher darf man diese Unternehmen nicht schlechtreden. Sei es durch Standardisierung, durch Funktionsumfang, durch betriebsstabile Systeme (dabei ist nicht die Sicherheit gemeint) oder durch den professionellen Support haben es diese Marken dazu gebracht, dass sie weltweit eingesetzt werden und man ihre Namen in der Wirtschaft schon fast genauso gut kennt wie Coca Cola. Unternehmen geben auf der anderen Seite genau deswegen mehr Geld aus und kaufen sich teure Produkte und Dienstleistungen von solchen Firmen ein, weil sie der Meinung sind, dass sie einen besseren Support, verlässliche Wartungsverträge und insgesamt bessere Qualität bekommen werden. Ist das eigene KnowHow mal nicht vorhanden, kann man dann über Distributoren oder Service Dienstleister das fehlende Wissen einkaufen und die Wissenslücken schliessen.

Die Popularität der Produkte dieser Hersteller in Zusammenhang mit ihrem Marktanteil verbunden mit ihren Verwundbarkeiten machen mir dabei allmählich sorgen. Wenn ein Hersteller wie CISCO also so manche seiner Lücken erst durch ein Leak von Tools erfährt, die angeblich aus dem Hause NSA stammen, dann sollte man sich einmal fragen, wie sehr man sich auf die Produktreife verlassen darf, bevor solche Produkte auf den Markt losgelassen werden. Vor allem frage ich mich aber, wie sehr ich mich dann auf Produkte verlassen darf, die aus dem Land kommen, welches Sicherheit und Unsicherheit zugleich verursacht und daraus einen undefinierbaren Zustand beim Konsumenten bewirkt.

Ein anderes Beispiel ist der Hersteller Juniper. Immer wieder kommen Sicherheitsmeldungen hervor, deren Ursache bzw. die genannten Schwachstellen in ihrer Art und Weise eigentlich bei solchen Herstellern erst garnicht auftreten sollten. Doch es ist immer wieder der Fall.

Wenn also so viele bekannte Hersteller, soviele Probleme mit der Sicherheit ihrer „Sicherheitsprodukte“ haben, wie effektiv ist es dann noch, heterogene Sicherheitskomponenten in einem Unternehmen einzusetzen, um bei einer möglichen Kompromittierung eines Systems, ein weiteres System als zweites Sicherheitssystem dahinter aufzustellen, welches nicht die gleichen Lücken aufweist. In Zusammenhang mit der Trägheit der Unternehmen ihre Systeme zeitnah gegen Verwundbarkeiten zu patchen entsteht hieraus ein höheres Risiko, welches andernfalls doch im Grunde ein sehr geringes Risiko darstellen sollte. Abgesehen von der Trägheit der Unternehmens-IT und der mittlerweile anscheinend nicht mehr verlässlichen Hersteller setzen viele Unternehmen zwecks Einsparungen oder Hinauszögerungen immernoch zu viele solcher Produkte ein, die bereits seitens des Herstellers entweder mit „End of Life“ oder mit „End of Support“ markiert wurden. Man geht das Risiko bewusst ein, weil man der Meinung ist, dass ein System, welches weniger gepatcht werden musste, auch zwangsläufig weniger Sicherheitslücken haben müsste. Ein weiterer Grund ist oft, dass zwar aktive Sicherheitssysteme als kritisch wahrgenommen werden, aber ihre passiven Derivate wie Switches, passive Router oder aber auch aktive Router nicht als sicherheitsrelevante Systeme angesehen werden. Welch ein Trugschluss.

In so manchen Prüfungen fallen dann auch diese Systeme aus dem Raster. Welcher Auditor kennt sich schon mit den ohnehin unübersichtlichen Firmware-Versionen von Herstellern zu all ihren sicherheitsrelevanten Systemen aus, oder haben mal zuvor über die Versionsstände von Cisco, Fortinet oder Checkpoint recherchiert. Die meisten Auditoren wissen noch nicht einmal, wie sie sich an solch einer Konsole zurechtfinden sollen. In solchen Situationen ist dann auch das Papier geduldiger, als so mancher Angreifer, der genau auf diese Betriebsblindheit wartet. Das Resultat daraus ist nicht weniger als ein im Unternehmen platzierter Advanced Persistent Threat, der lange Zeit unentdeckt bleibt, wie es z.B. bei der RUAG in Bern zuletzt öffentlich der Fall war.

Ich empfehle mittleren und grösseren Firmen der Top 30 Branchen, die im Fokus der NSA bzw. nun deren Tools sein könnten und Produkte von CISCO, Juniper, Fortinet oder Checkpoint etc. im Einsatz haben, ihren Perimeter-Sicherheitssystemen dringend alternative Schutzsysteme vorzuschalten und diese mindestens 2 Jahre in Betrieb zu halten.

Unternehmen sind täglich im Blindflug, es ist ja noch nie was passiert…

Wie gut ist Ihr Unternehmen eigentlich aufgestellt, wenn es um die aktive Überwachung ihres Unternehmensnetzwerks, und somit all ihrer Systeme und Informationen geht?

Wie gut ist ihr IT Verantwortlicher darüber informiert, ob ein Teamleiter nicht doch seine Administratoren für andere Tätigkeiten vom Monitoring befreit hat?

Haben sie überhaupt ein dediziertes, technisches Sicherheitsteam? Oder ist ihnen das zu teuer? Haben sie bereits einen definierten Plan, Prozesse zum Incident Response, im Falle eines Falles?

Wie gut kennt sich ihr Personal mit dem lesen und interpretieren von Log-Informationen aus?

Werden diese überhaupt gesammelt, um einen Hergang rekonstruieren und nachvollziehen zu können?

Wie gut sind ihre „Data Leakage & Loss Prevention“ Systeme und Prozesse aufgestellt bzw. können sie diese messen?

Was denken sie, wie gut sie die Datenschutzgesetze in ihrem Land einhalten?

Und sind sie sich da wirklich sicher, dass nicht bereits kompromittiert wurden?

Es ist erschreckend immer wieder anzusehen, dass so viele Unternehmen ihre Sicherheit schwerwiegend nach den Standards ausrichten, die sie erfüllen müssen und weil es nunmal kostspielig ist alle diese Regularien so zu erfüllen wie sie gefordert werden, anfangen zu tricksen oder sie ausserhalb der Audit Saison zu ignorieren.

Ein mir bekanntes Unternehmen hatte sich einen teuren Envision Server von RSA beschafft. Dieser Server kann mit jeglichen angefallenen Logs gefüttert werden und bietet eine Logik, um die die Logs nach bestimmten Mustern, Ereignissen, sogenannten Use Cases auszuwerten. Das bekannteste Beispiel eines Use Cases ist u.a. „Wer hat sich mehr als 6 mal falsch angemeldet“ oder „Wer hat sich ausgesperrt“. In Envision neue Use Cases zu bilden ist nicht gerade „easy going“ aber es gibt zumindest eine detaillierte Dokumentation dazu und viele anderen Uses Cases kann man sich mit entsprechend technischem Wissen und krimineller Fantasie selbst ausdenken. Man muss dazu nur einen Netzwerk oder Firewall-Admin fragen, was er denn so alles versuchen würde, wenn er ein System oder ein Netzwerk kompromittieren wollte. Mal abgesehen davon, dass die Admins in diesem Unternehmen lediglich die von RSA mit diesem System gelieferten Standard Use Cases angewendet hatten, hatten sie weder die grosse Lust, noch die Zeit um sich mit dem aktiven Geschehen im und um das Unternehmensnetzwerk zu kümmern.Ich stellte dennoch die Frage, was sie denn noch so beobachten. Die Antwort war einfach „Ja nix, nur das was das System anzeigt“.

Auf meine Frage hin, wie sie denn sicherstellen würden, dass an den peripheren Sicherheitssystemen ein aktives Monitoring stattfinden würde, beantwortete man mir, dass dies die Aufgabe der Firewall Admins sei. Ich ging also zu der Abteilung der Firewall Admins. Schliesslich seien diese ja für die Sicherheit der gesamten Netzwerks verantwortlich. Nun der eine Admin war gerade dabei einen neuen Router zu konfigurieren. Auf seinem Tisch stapelten sich ausrangierte Switches, viele weitere Hardware wie Netzwerkmodule oder jede menge Kabel, Tastaturen etc. Der Anblick dieser unaufgeräumten Admin-Bude (um es milde auszudrücken) drängte in mir unweigerlich das Vorurteil auf, dass man so chaotisch arbeitet, wie man darin lebt. Der andere Admin war bereits um 15 Uhr auf dem Weg nachhause, weil er auf die Kinder aufpassen musste. „Und ausserhalb der Betriebszeiten? Wie überwacht ihr Annomalien in dieser Zeit?“ fragte ich den Sicherheitsverantwortlichen. Er antwortete mir ganz trocken „Das können wir so nicht überprüfen, da wir kein 24/7 Rechenzentrum sind“. „Ja und in den übrigen Betriebszeiten wohl auch nicht!“ ging mir sofort durch den Kopf. Immerhin war es ein RZ, welches IT Dienstleistungen für 4 mittlere und grössere Gesellschaften erbrachte. Seien wir aber Fair! Wenn man nur eine 98,7%ige Verfügbarkeit gem. den vereinbarten SLAs gewährleisten muss, dann macht das eine theoretische Ausfallzeit von ca. 5 Tagen, ohne Penalen in Kauf nehmen zu müssen. Ganze 5 Tage also, in denen man die potenziellen Risiken durch Reaktivismus und gelebtem Chaos wieder gut machen könnte. Niemand ist sich so richtig dessen bewusst, was nach einem Reputationsschaden durch Computereinbrüche und Cyberkriminalität erfolgt. Es ist ja noch nie was passiert…

Sie denken vielleicht, dass dies eines der wenigen Fälle im Leben ist und dass ich doch lieber aufhören sollte zu übertreiben. Ich habe für sie noch eine Anekdote (die Kurzfassung).

In eines der wahrscheinlich sichersten und grössten Rechenzentren Deutschlands war ich vor nicht allzu langer Zeit in Begleitung eines Audits. Wir waren in der Netzwerk-Session der Revision unterwegs und das Thema war das IDS System für geschäftskritische Abschnitte eines Teilnetzwerks. Bei solchen grossen Rechenzentren ist es ohnehin nicht sinnvoll und auch nicht möglich ein Sicherheitssystem für alle relevanten Netzwerkbereiche zu implementieren, auch wenn das System selbst redundant ausgelegt ist. Zu gross ist der Durchsatz (Traffic) und zu unübersichtlich das Monitoring. Zudem steigen die „False Positives“ proportional zur Anzahl der zu überwachenden Subnetze. Am Ende würde kein Admin mehr durchblicken, was Spross und was Weizen ist.

Im sogenannten Konsolenaudit führten die Experten das Monitoring des teuren Systems vor und zeigten die Meldungen auf, wie diese bewertet werden würden und was man bei suspekten Vorgängen bzw. Meldungen prozesstechnisch einleiten würde. Dabei arbeitete man natürlich neben den vom Hersteller gelieferten Patterns und vorgenommenen Konfigurationen auch mit manuellen Anlernprozessen des Systems. Das Monitoring selbst erfolgte dabei auf Basis von Filterregeln, deren Output für die aktive Überwachung relevant sein sollten. Mich interessierten neben all diesen Meldungen aus dem Traffic noch die bislang verdrängten, nicht angezeigten Meldungen. Mich interessierten die regulären Meldungen bedingt. Ich war an den Fehlermeldungen des Systems interessiert. Ein Admin meinte, es sei uninteressant, da das System aufgrund von nicht aufgelösten Abhängigkeiten oftmals Fehlerprotokolle erzeugen würde. Ich war dennoch neugierig und lies mir einpaar dieser ausgeblendeten Logs anzeigen. Ein Abschnitt fiel mir dabei besonders auf. Das IDS System meldete, dass es anhand einer SOCKS Tunnelung das darin getunnelte, eigentliche Übertragungsprotokoll nicht analysieren könnte. Ein weiterer Blick stellte bei mir alle Ampeln auf Rot! Man hat irgendwo die von der Firewall blockierte und nach den zu erfüllenden Sicherheitsstandards verbotene FTP Protokoll kurzerhand über eine SOCKS Proxy Verbindung getunnelt um das unsichere FTP Protokoll aufgrund von starken Software-Abhängigkeiten dennoch nutzen zu können. Diese Schlawiner 😀 Solch eine Übertragung erscheint im ersten Augenblick natürlich völlig legitim und fällt weder dem Firewall Team auf, noch dem IDS Team. Letzteres Team hatte ja Fehlerprotokolle ohnehin ausgeblendet und auch wenn sie es nicht täten, zweifelte ich daran, dass sie den Zusammenhang zwischen dem genutzten und dem Reglement des Sicherheitsregelwerks verstanden hätten. Weitere Recherchen und Klarstellungen stellten heraus, dass die Anwendungsabteilung das Problem mit dem unsicheren Protokoll nicht lösen konnte und für das bevorstehende Audit auf diesem Weg geschummelt hat 😀 Böse Jungs 😉 Das über diesen Weg Abrechnungsdaten an einen entfernten Standort über das Internet übertragen wurde und jeder, der in diese Verbindung reinschauen konnte, die FTP Authentifizierung sowie die Daten abfangen könnte, war den Beteiligten anscheinend egal.

Das Problem, dass sich für viele viele Unternehmen als enormes Risiko entpuppt, könnte man mit wenigen Punkten aufstellen:

- Die als Professionell geltenden Hersteller von Sicherheitsprodukten sind unzuverlässig um nicht zu sagen fahrlässig geworden. Eine Kombination von Herstellerprodukten lässt den CISO heute nicht wirklich besser schlafen. Eine „Liability Shift“ zudem in Richtung Hersteller gibt es nach wie vor nicht. Ganz anders bei den Payment Brands wie VISA oder Mastercard: Die Verantwortung nach dem Missbrauchsfall liegt immer bei den Partnern, auch wenn das Kreditkartensystem heute selbst veraltet und unsicher ist und man die Sicherheit ständig drum herum versucht zu bauen.

- Die Unternehmen sind betriebsblind, wissen nicht wirklich was gerade eben in ihrem Netzwerk passiert, weil sie in dem Glauben leben, dass sie durch die alleinige Installation und Einrichtung von diesen Komponenten einen ausreichenden Schutz haben. Dabei kommt die proaktive Überwachung des Unternehmensnetzwerk zu kurz, wenn sie überhaupt existiert. Die richtige Konfiguration und das aktive Monitoring ist wichtig für die Frühzeiterkennung von Bedrohungen.

- Abteilungen versuchen Abhängigkeiten durch Schatten-ITs oder Work-Arrounds zu lösen, da sie sich nicht auf ihre IT Abteilung verlassen wollen oder es ihnen zu kompliziert oder zu teuer erscheint

- Man betrachet den Verkehr von Aussen nach Innen als den bösen Verkehr, vernachlässigt jedoch den umgekehrten Weg massiv. Auch hier ist man blind, denn niemand weiss, welche Systeme ausserhalb der Unternehmensgrenzen angesprochen werden, weil sie nicht kontrolliert werden. Es gibt keine IP-Syndication und auch keine Blacklists nach Regionen.

- Die heutigen innovativen Sicherheitssysteme bauen leider auf maroden und verfaulten Stelzen auf. Protokolle, die heute unsere tägliche Kommunikation gewährleisten, wurden in den 70’ern bis 90’ern entwickelt und sind gegen die heutigen Bedrohungen nicht gewappnet. Gleichwohl sind sie zu global im Einsatz, um sie nach heutigen Kriterien zu transformieren geschweige denn zu ersetzen.

Unternehmen benötigen mehr „Standard KnowHow“ statt „Extreme Standardization“

Aber was soll man gegen diese Defizite tun? Unternehmen sollen sich standardisieren um ihre Prozesse schlank und möglichst effizient und ihre Kosten unter Kontrolle zu haben um z.B. Reibungsverluste durch viele Sonderlocken und Extrawürste zu vermeiden. Gleichzeitig sollen sich die eigenen Fachexperten mit den geschaffenen Strukturen und Systeme bestens auskennen um eine stetige Qualität der Leistungen und in diesem Falle auch der Sicherheit zu gewährleisten.

Die Lösung dieses Dilemmas „Risiko durch Extrem-Standardisierung“ (Ich nenne es Mainstreaming) liegt in der Schaffung einer Balance: zwischen dem Weg der stupiden Standardisierung aus Optimierungswahn und Zwängen und der Heterogenität aus Sinnhaftigkeit und Risikooptimierung heraus. Haben sie sich einmal die Mühe gemacht und sich die Stellenanzeigen im Markt für solche Tätigkeiten angeschaut? Die Suchkriterien vieler Unternehmen sind gleich. Firmen suchen dann Experten, wenn entweder eine Stelle frei oder geschaffen wird. Bei der Suche nach geeignetem Fachpersonal konzentriert man sich beiden Anforderungen dabei um die die Frage „Was muss der Kandidat oder die Kanditatin an Produkten und Lösungen beherrschen“ statt „Was bringt der Kandidat mit, um meine Produkte und Lösungen zu beherrschen“. Glauben sie, dass ein A320 Pilot in der Lage ist in kurzer Zeit auch eine Boing 737 zu fliegen? Warum wollen sie dann unbedingt einen Boing 737 Piloten einstellen, wo sie doch die Wahl zwischen 3 exzellent ausgebildeten und erfahrenen A320 Piloten haben? Und woher wissen wir, dass ein Boing Pilot den Flieger besser und sicherer fliegen wird, wenn evtl. eines der anderen 3 Piloten wesentlich mehr Flugstunden besitzen? Wird ein Cisco zertifizierter Firewall Admin die Sicherheit besser beherrschen, als ein nicht zertifizierter? Wo können wir die Unterschiede messen? Können wir ein besseres Standard-Niveau der gezielten Sicherheit durch vorgelegte Bescheinigungen erwarten? Oder ist es nicht doch besser, Mainstream gegen Independence antreten zu lassen? Wir messen unsere Sicherheit heute leider durch Standards, nicht durch unsere eigenen Messgrössen, die solche Standards anreichern sollten und erst dadurch eine messbare Sicherheit entsteht.

Ein Problem bei der Auswahl von geeignetem Personal sind die Vorauswahlprozesse, meistens durch die interne HR Abteilung. Sie sind Experten in ihrem Gebiet, aber Dilettanten wenn es darum geht eine geeignete Vorauswahl für spezielle Fachabteilungen zu treffen. Deswegen gehen viele nach Checklisten und Standardbefragungen durch und lassen auch mal den einen oder die andere herausragende Kandidatin hinten durchfallen. Beispielsweise wird ein gesuchter Sicherheitsexperte dann vorgezogen, wenn er die bevorzugten Kriterien vorweisen kann. Ein Kriterium für die Bevorzugung könnte sein, dass der Kandidat im Besitz von „Mainstream“ Zertifikaten ist, z.B. eines CISM Zertifikats. Analog zur Namhaftigkeit so mancher Hersteller, haben sich auch Zertifikate Herausgeber Namen geschaffen. Das genannte Beispiel CISM ist ein Programm der ISACA und der Schulungsinhalt sagt in keinster Weise aus, dass ein nach CISM zertifizierter Kandidat in der Praxis auch weiss, was er da sicherheitstechnisch von sich gibt. Dennoch wird er aufgrund der Mainstream Denke bevorzugt, ist u.U. jedoch keine praktische Hilfe für das Sicherheitsteam innerhalb der IT, da er sich bislang überwiegend mit dem konzeptionellen, der Theorie beschäftigt hat.

Ein weiteres Problem stellt die Tatsache dar, dass viele CIOs schlichtweg den anfangs umständlichen Weg der KnowHow Anreicherung nicht bevorzugen. Stattdessen wird eine IT Strategie anhand von Marken und Dienstleistern gebildet. Die Strategie könnte lauten, dass man im Unternehmen aus den und den Gründen durchweg auf Cisco oder Juniper Produkte im Netzwerk Bereich setzen wird, während man im Client und Server Bereich durchweg Microsoft Produkte zum Einsatz bringt, mit Hardware von IBM, DELL oder HP. Dagegen ist erst einmal nicht auszusetzen, wenn da nicht noch die weitere Strategie wäre, dass man alles, was von diesen Produkten abweicht, einem Outsouring Unternhemen übertragen würde. In solchen Strategien hat man sich die Hintertür zur Flexibilität im KnowHow und in der Einsatzbreite der IT Belegschaft schon selbst zugehauen und gleichzeitig eine gewisse Abhängigkeit erschaffen. Die Abhängigkeit zum Sicherheitsniveau der Hersteller und zu Ihrer Service-Motivation.

Zu einer gesunden Fallback-Planung in der Strategie gehören auch immer Alternativlösungen, die entweder im Falle eines Falles zum Einsatz kommen, oder in einer Multiplattform-Architektur bereits ihren Platz einnehmen. Das einfachste Beispiel dabei könnte sein, in dem z.B. ein CIO als Strategie für die Peripheriesicherheit auf alternative Firewallsysteme wie IPCop oder IPFire setzt, während der innere, wesentlich dynamischere Bereich durch Herstellerprodukte aus seinem Standardisierungsprotfolio kommen. Zugleich sollte es nicht die Strategie sein, aktive und passive Netzkomponenten zu homogenisieren, stattdessen eine Zonenstrategie mit heterogenen Herstellern zu realisieren. Auf wenn eine Cisco Switch angeblich betriebsstabiler sein soll, braucht man z.B. in einem wesentlich unkritischeren Bereich einen teuren Switch, oder würde es eins von einem anderen Hersteller auch tun, wenn man nicht unbedingt VTP im Einsatz hat, um ständig neue VLAN Truncs zu bilden oder umzukonfigurieren. Ist es nicht sicherheitstechnisch doch besser, bei einem möglichen Zero-Day Angriff durch den Einsatz unterschiedlicher Komponenten einem fehlenden Patch seitens des Herstellers entgegen zu wirken? Diese heterogene Sicherheitsstrategie gilt gleichermassen für Viren- und Malware Scanner im Unternehmen. Das Prinzip dabei sollte allen klar sein: Vier Augen sehen mehr als nur zwei.

Nicht nur die Standard-Denke ist das Problem, denn Best-Practice ist nicht immer die beste Praxis

Einer der grössten bisherigen Innovationen von bösartigen IT Genies war es die Schad- und Erpressungssoftware (Ransomware) wie Locky, CryptoLocker oder Petya auf die Menschheit loszulassen. Dabei ist das Mechanismus bzw. die Möglichkeit der digitalen Erpressung auf dem eigenen heimischen oder Arbeits-PC denkbar einfach und diese Schadsoftware macht nicht einmal etwas durch Aushebeln von Sicherheitsmechanismen des zugrunde liegenden Betriebssystems, sondern nutzt einfach ausgedrückt das Recht des Benutzers, um seine Daten ggf. unwiderkehrlich zu verschlüsseln, es sei denn, man zahlt, oder hat den Schlüssel anderweitig bekommen, z.B. durch die Hilfe von http://www.bleepingcomputer.com oder durch das Aufgeben der Angreifer selbst, wie es bei TeslaCrypt der Fall war.

Dabei waren die Meldungen durch das heise Security Team im Frühjahr 2016 mit den Schlagzeilen „Krypto-Trojaner Locky wütet in Deutschland: Über 5000 Infektionen pro Stunde“ einfach nur erschreckend. Gut, zu dieser Zeit bin ich sicher nicht so stark betroffen davon, da ich als Linux User zum eher geringeren Beuteschema dieser Schadsoftware passe, obwohl es auch unter diesem Betriebssystem funktioniert und einpaar Linux Portierungen der Erpressungs-Software bereits gesichtet wurde. Doch die Masse setzt weiterhin auf Microsoft und MAC Betriebssysteme und das Ausmass an Verseuchungszenarien in einem Unternehmen mit einem Unternehmensnetzlaufwerk gleicht wohl einer Katastrophe. Ich will nicht daran denken, welchen Ausfall solch eine mögliche Infizierung für ein Unternehmen bedeuten würde, wenn nicht nur das lokale System zum opfer fällt, sondern auch gleich alle vom betroffenen User beschreibbaren Daten auf einem solchen File-Server. Ich hoffe, dass in solchen Fällen die Unternehmen ein funktionierendes „Business Continuity & Desaster Recovery Plan“ vorweisen können. Ich glaube jedoch weniger daran. Meine Erfahrungen zeigen, dass in den gefühlt tausend Unternehmen, die ich bisher kennenlernen durfte, allenfalls 10% darauf vorbereitet sind. Wie bereits auf eine andere Art ausgedrückt: Papier ist geduldig und es wird immer noch fleissig gedruckt 😉

Ein Umdenken ist notwendig!

Es liegt nahe sich das Zugeständnis zu machen, dass wir mit unseren heutigen Schutzmassnahmen, u.a. jedoch auch insbesondere gegen Angriffe von Ransomware nicht ausreichend vorbereitet sind/waren. Es ist seit der ersten Registrierung solch eines massiven Angriffs ein Katz- und Mausspiel zwischen den „Bad Guys“ und den Antivirus-Herstellern geworden. Heuristisch gesehen ist es sehr schwer Derivate von solchen Malware zu entdecken, während Mutationen von bereits bekannt gewordener Malware wohl einfacher zu identifizieren sind und dadurch mit einer grösseren Wahrscheinlichkeit blockiert werden können, noch bevor sie einen Schaden anrichten können. Eine Garantie gibt es jedoch nicht. Es hängt stets davon ab, wie effektiv die eingesetzte Antivirus Software ist und wie schnell die Hersteller auf Mutationen reagieren.

Eines der viel effektiveren Lösungen zum Schutz vor solcher Schadsoftware liegt im Grunde bereits länger in der Hand. Die Endpoint Security, wie wir sie heute im grossen Stil zum Einsatz bringen ist nicht effektiv genug gegenüber bekannten oder in diesem Fall bis zu ihrem Erstauftritt völlig undenkbaren Bedrohungen wie Ransomware. Im Zuge der Veränderungen der IT Welt durch die Virtualisierungstechnologie, hat sich die Technologie selbst rasant entwickelt und bietet neue Möglichkeiten zur effizienten und ökologischen IT Infrastruktur. In Folge dessen sind viel Lösungen entstanden bzw. optimiert worden, die uns nicht nur im täglichen Leben unsere Betriebsabläufe effektiver oder kostengünstiger gestalten. Sie könnten auch dazu genutzt werden, um die Gefahren, denen wir unsere Mitarbeiter ahnungslos aussetzen, einen Schritt mehr fernzuhalten, damit wir das gesamte Unternehmen schützen. Ahnungslos ist der Mitarbeiter deswegen, weil er durch seine Naivität nun mal mehr Schaden verursachen könnte, auch wenn er die technischen Rechte nicht hätte. Stellen sie sich einen Mitarbeiter vor, der an einem wichtigen Projekt für das Unternehmen arbeitet, aber aus Vertraulichkeitsgründen die Daten erst mal lokal speichert. Er hat auch nicht daran gedacht regelmässig Sicherungskopien zu erstellen. Nun wird sein System infiziert, weil er auf eine Phishing-Email reinfällt. Das was ich ihnen erzähle, ist kein schlechter Scherz aus einem Hollywood-Streifen 2. Klasse. Es ist unsere Realität heute in Europa.

Der Mensch ist wie gesagt ein Gewohnheitstier und er will am besten den Weg des geringsten Widerstands gehen. Doch beim zweiten Hinschauen merkt man, dass ein anderer, effektiverer und am Anfang vielleicht ungewohnter Weg, der bessere zum Schutz der Daten und Informationen sich herausstellt. Was wir bereits für viele Geschäftszwecke immer mehr zum Einsatz bringen, könnte in einer anderen Betrachtungsweise auch zum Schutz der bereitgestellten Mittel und Systeme führen. Die rede ist hierbei von der Container-Technologie.

Container sorgen u.a. dafür, dass Software verlässlich läuft, nachdem sie von einer Umgebung in eine andere versetzt worden ist. Beispielsweise kann Software vom Notebook des Entwicklers in eine Testumgebung, von dort in die Produktion oder von einem physikalischen Computer in einem Rechenzentrum auf eine virtuelle Maschine (VM) in einer privaten oder öffentlichen Cloud übertragen werden, ohne dabei die Betriebssystemabhängigkeiten berücksichtigen zu müssen. Wenn keine Hardware angefasst werden soll, dann sollte man Virtualisierung einsetzen.

Der Vorteil liegt darin, dass man beim Einsatz von Container basierter Software eine direkte Interaktion mit dem zugrunde liegenden Betriebssystem unterbinden kann. Applikationen wie E-Mail Clients (Outlook, Thunderbird, etc.) oder Internet Browser können als Container Software gestartet und genutzt werden, ohne dass der Benutzer sich und das Unternehmen durch ein Fehlverhalten in Gefahr bringt. Daten, die heruntergeladen werden müssten, könnten in einem Quarantäne Bereich abgelegt werden, um dort erst einmal gegen Schadsoftware überprüft zu werden. Dabei könnte man unterscheiden, ob die Dateien aus einer nicht vertrauenswürdigen oder internen Quelle stammen um die Bearbeitungszeit zu verkürzen. Sollte einmal ein Container-Image z.B. durch eine Ransomware verseucht werden, kann sie durch einen anderen Container binnen Minuten ersetzt, die verseuchte Variante zur weiteren Untersuchung und forensische Zwecke isoliert werden. Es wäre zudem auch denkbar, dass man die Interaktion zwischen einem Container Image und des Endbenutzersystems für bestimme Ausnahmefälle frei gibt um die Betriebsprozesse zu optimieren. Diesbezüglich sollte es jedoch eine Voraussetzung sein, eine vorangehende Risikoanalyse durchzuführen.

Welchen Unterschied machen Container im Gegensatz zu Virtuellen Maschinen in der Praxis? Ein Container mit demselben Inhalt wie eine Virtuelle Maschine (VM) enthält wesentlich weniger Daten, also Bytes. Im Gegensatz zu einer VM sprechen wir hierbei von Megabytes. Daher kann ein Client oder Server auch sehr viel mehr Container betreiben als VMs. Zudem benötigen VMs mehr Zeit zum zu booten, Apps in Container dagegen stehen fast sofort zur Verfügung.

Es liegt also nahe, dass diese revolutionierende Technik auch zum Schutz der Unternehmenswerte und Menschen zum Einsatz kommen sollte. Mitarbeiter bzw. die Endpoint Security bei den sogenannten „Internet Facing“ Systemen wäre durch eine Abstrahierung der Interaktion wesentlich geschützter und im Falle eines Falles wären die Wiederherstellungsprozesse einfacher, als bisher. Diese Art von Schutzmassnahmen sind aber nicht nur bei Client Systemen denkbar. Auch Server Systeme könnten kritische Applikation auf eine ähnliche Weise abbilden und die IT Betriebsprozesse hinsichtlich Vertraulichkeit, Integrität und Verfügbarkeit optimieren.

Leider sind wir überwiegend noch der Meinung, dass es Best Practise wäre, u.a. Client Systeme nach wie vor auf die klassische Weise zu „imagen“ und auszurollen. Dabei werden Client Images so konfiguriert, dass alle Basis Applikationen aus dem Client Portfolio des Unternehmens auf ein Referenzsystem geladen werden und dann ein Master Client Image daraus erstellt wird. Fehler versucht man dann über den Service Support im 1st Level oder dann Vorort 2nd Level zu lösen. Mainstream eben!

Es gibt noch viele weitere Beispiele, wo Best-Practice einfach nicht mehr beste Praxis ist, sondern nur aus betrieblicher Unflexibilität und fehlender Motivation so gelebt wird.

Mein Fazit

Unternehmen sind heute noch immer nicht gegen aktuelle Bedrohungen ausreichend vorbereitet. Der Anschein, dass sie durch die Umsetzung eines oder mehrerer Sicherheitstandards dem gewünschten Schutzbedarf mit entsprechendem Niveau begegnen, ist nach wie vor ein Trugschluss und gibt allenfalls den Akkreditoren durch Snapshot-Auditberichte ein gutes Gefühl. Die zuvor genannte Achterbahnfahrt ist das reale Bild von der gewünschten und seitens der Standardisierer geforderten Kontinuität. Oft bleiben dabei wichtige Meilensteine wegen Umpriorisierungen auf der Strecke. Insbesondere die „CHECK“ Komponente leidet heute massiv unter dem wirtschaftlichen Druck, dem viele Unternehmen ausgesetzt sind. Aber auch das „DO“ ist heute nicht unbedingt auf einem kontinuierlichen Level, der einen ausreichenden Schutz gewährleisten würde. Wenn man es wort wörtlich nennen darf, ist „Ausreichend“ im deutschen Notensystem eine Note 4. Wollen Sie tatsächlich neuen Hypes wie z.B. das IoT die Note 4 in Sachen „Sicherheit“ geben?

Es muss ein Mind-Change und der Wille entstehen, das Thema ernst zu nehmen, wie es mit dem gesunden Menschenverstand der Fall wäre. Das Sicherheits- und Risikobewusstsein muss auf Augenhöhe mit dem Profitwunsch gestellt sein. Es sollten dabei unbedingt alternative und integrale Lösungswege zur nachhaltigen Sicherheit mit-betrachtet werden, um die Gefahren im Falle eines Falles abzuwehren, denen sich Unternehmen durch ihre Mainstream-Denke und Mainstream Beratung selbst bewusst oder unbewusst aussetzen.

In den Köpfen unserer Führer gilt es soviel Eigenkapital zu bilden, dass man aus den erwirtschafteten Rücklagen, die Risikokugel am eigenen Pylon abprallen lassen kann, ohne dabei umzufallen. Dann muss man sich über die paar Splitter auch keine Gedanken mehr machen. Das ist die Planwirtschaft unseres heutigen Kapitalismus.

orkix

(red)